一、robots文件是什麽?

二、robots文件的作用

三、如何編寫robots文件

四、robots文件常見問題

五、robots文件實例講解

六、robots文件中的Sitemap指令

七、用戶代理指令User-agent

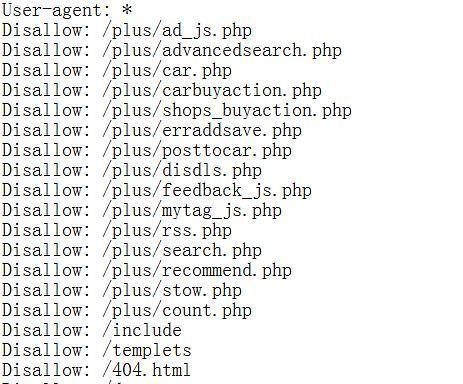

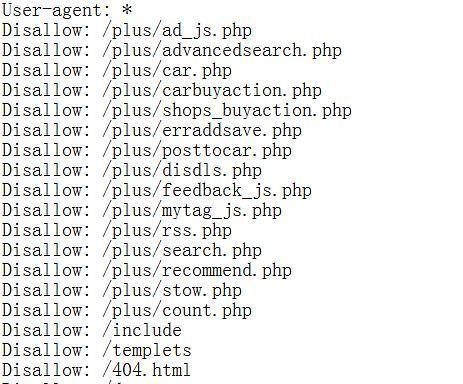

八、Disallow指令

九、Allow指令

十、Crawl-delay指令

十一、Noindex指令

十二、Nofollow指令

十三、Host指令

十四、關於robots文件更新

十五、與展望

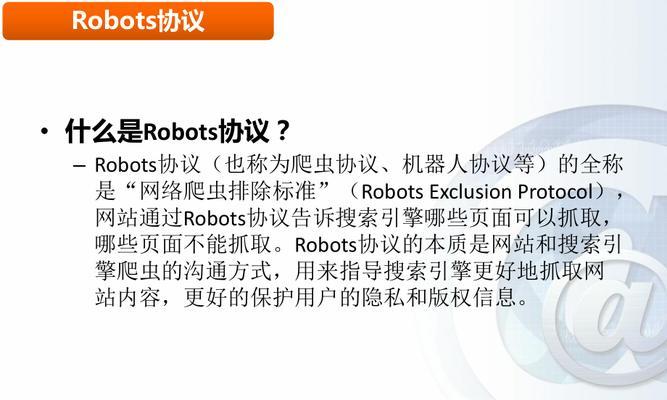

一、robots文件是什麽?

哪些頁麵不可以被抓取,robots,它告訴搜索引擎爬蟲哪些頁麵可以被抓取,txt是一個文本文件。並通過鏈接http://www、com/robots,它通常位於網站的根目錄下,example,txt進行訪問。

二、robots文件的作用

哪些頁麵不可以被抓取,其一是告訴搜索引擎爬蟲哪些頁麵可以被抓取、robots文件的作用主要有兩個方麵;網站的更新頻率,包括網站所有者,其二是為搜索引擎提供一個關於網站的基本信息,網站的Sitemap等。

三、如何編寫robots文件

其次是必須放置在網站根目錄下,首先是必須是文本文件,編寫robots文件需要遵循一些基本原則、最後是必須使用UTF-8編碼格式。編寫時需要注明User-即指定搜索引擎爬蟲的類型、agent,並設置相應的指令。

四、robots文件常見問題

沒有添加Sitemap指令等,在編寫robots文件過程中,常會遇到一些問題、如robots文件無法訪問。以確保robots文件的有效性、這些問題需要針對性地解決。

五、robots文件實例講解

我們以一個實際的例子進行講解,為了更好地理解robots文件的應用。則可以使用Disallow指令,一家餐廳網站希望搜索引擎爬蟲不要抓取其網站上的菜單頁麵。

六、robots文件中的Sitemap指令

它為搜索引擎提供了網站的地圖,哪些不需要、告訴搜索引擎哪些頁麵需要被收錄,Sitemap指令是robots文件中最為重要的一項指令之一。

七、用戶代理指令User-agent

User-它告訴搜索引擎使用哪種類型的爬蟲來抓取網站,agent指令是robots文件中必須的一項指令。Baiduspider等,常見的爬蟲包括Googlebot。

八、Disallow指令

Disallow指令告訴搜索引擎哪些頁麵不可以被抓取。購物車頁麵等,某些網站可能希望不被收錄的頁麵包括登錄頁麵。

九、Allow指令

Allow指令告訴搜索引擎哪些頁麵可以被抓取。則以Allow指令為準、如果Disallow指令與Allow指令相衝突。

十、Crawl-delay指令

Crawl-避免對網站造成過大的訪問壓力、delay指令可以控製搜索引擎爬蟲的訪問頻率。某些網站可能希望設置訪問間隔為5秒鍾。

十一、Noindex指令

例如一些測試頁麵或暫時下架的商品頁麵等,Noindex指令告訴搜索引擎某些頁麵不應該被收錄到搜索結果中。

十二、Nofollow指令

即不應該影響到被鏈接頁麵的排名,Nofollow指令告訴搜索引擎某些鏈接不應該被傳遞權重。

十三、Host指令

Host指令用於告訴搜索引擎網站的主機名和端口號。com和example、example,某些網站可能同時支持www,需要在robots文件中添加相應的Host指令,com兩個域名。

十四、關於robots文件更新

否則會導致搜索引擎爬蟲無法正確抓取網站頁麵,robots文件也需要隨之更新,隨著網站內容的不斷更新。需要注意不要影響到已有的指令,在更新robots文件時。

十五、與展望

相信讀者已經了解了robots文件的作用及應用,通過本文的介紹。為網站優化提供更加便捷的服務,隨著互聯網技術的不斷發展、robots文件也將逐漸智能化、未來。

了解網站的Robots文件

可以幫助我們控製搜索引擎爬蟲對網站的抓取行為,網站的Robots文件是一個重要的控製文件。我們將探討Robots文件的作用和如何使用它來控製搜索引擎的爬蟲行為、在這篇文章中。

什麽是Robots文件?

用於告訴搜索引擎爬蟲哪些頁麵可以被抓取,Robots文件是一種文本文件,哪些頁麵不可以被抓取。Robots文件通常被放置在網站的根目錄下。

為什麽需要Robots文件?

Robots文件是一種可以幫助我們控製搜索引擎爬蟲行為的文件。包括那些你可能不想被搜索引擎收錄的頁麵,如果沒有Robots文件,搜索引擎爬蟲將會抓取整個網站。

如何創建Robots文件?

創建Robots文件非常簡單。將其命名為,隻需要在文本編輯器中創建一個空白文本文件“txt,robots”並將其放置在網站的根目錄下即可、。

Robots文件的基本語法是什麽?

一個是User,Robots文件的基本語法由兩個部分組成-另一個是Disallow,agent。User-Disallow表示不允許抓取的頁麵,agent表示搜索引擎爬蟲的名稱。

如何定義可以被搜索引擎抓取的頁麵?

如果想讓搜索引擎抓取整個網站,可以在Robots文件中添加如下

User-agent:*

Disallow:

這個代碼塊表示允許所有的搜索引擎爬蟲訪問整個網站。

如何定義不可以被搜索引擎抓取的頁麵?

如果你不希望搜索引擎抓取某個頁麵,可以在Robots文件中添加如下

User-agent:*

Disallow:/page.html

html頁麵,這個代碼塊表示不允許所有的搜索引擎爬蟲訪問/page。

如何定義某個搜索引擎不能抓取某個頁麵?

如果你隻想禁止某個搜索引擎抓取某個頁麵,可以在Robots文件中添加如下

User-agent:Googlebot

Disallow:/page.html

html頁麵,這個代碼塊表示隻禁止Googlebot爬蟲訪問/page。

如何允許搜索引擎訪問某些特定的頁麵?

如果你隻想允許搜索引擎訪問某些特定的頁麵,可以在Robots文件中添加如下

User-agent:*

Disallow:/

Allow:/page1.html

Allow:/page2.html

html和/page2、html頁麵,這個代碼塊表示隻允許搜索引擎訪問/page1。

如何禁止搜索引擎訪問某些特定的目錄?

如果你希望禁止搜索引擎訪問某些特定的目錄,可以在Robots文件中添加如下

User-agent:*

Disallow:/admin/

Disallow:/private/

這個代碼塊表示不允許搜索引擎訪問/admin/和/private/目錄。

Robots文件的其他常用指令是什麽?

Robots文件中還有其他常用指令,比如:

Sitemap:該指令告訴搜索引擎網站的Sitemap文件的位置。

Crawl-delay:以避免對網站造成過大的負荷,該指令告訴搜索引擎爬蟲每次抓取的時間間隔。

Robots文件的編寫需要注意哪些問題?

編寫Robots文件時需要注意以下幾點:

1.應該放置在網站的根目錄下,不要將Robots文件放置在子目錄下。

2.比如管理員賬號密碼等、不要將敏感信息包含在Robots文件中。

3.否則搜索引擎爬蟲無法讀取文件內容,不要將Robots文件設置成隻讀模式。

如何測試Robots文件的效果?

可以使用GoogleSearchConsole的robots,txt測試工具,為了測試Robots文件的效果。該工具可以幫助你檢查Robots文件是否設置正確。

Robots文件在SEO中的作用是什麽?

Robots文件在SEO中扮演著重要的角色。從而提高網站的SEO效果,它可以幫助我們控製搜索引擎爬蟲的抓取行為。

如何應對Robots文件被黑客攻擊的情況?

可能會導致搜索引擎爬蟲抓取到一些敏感信息,如果Robots文件被黑客攻擊。可以定期檢查Robots文件是否被修改過、為了避免這種情況發生、並及時進行修複。

Robots文件是網站控製搜索引擎爬蟲行為的重要工具。能夠幫助我們更好地控製搜索引擎的爬取行為,了解Robots文件的語法和使用方法、從而提高網站的SEO效果。

">淺談網站robots文件的作用與應用(了解robots.txt) ***** 網站已成為企業推廣,而如何提高網站的訪問量和收錄量成為網站運營者必須關注的問題,品牌宣傳的重要途徑,隨著互聯網的發展。robots文件扮演著重要角色、而在這個過程中。為廣大網站運營者提供幫助,本文將介紹robots文件的作用及應用。

一、robots文件是什麽?

二、robots文件的作用

三、如何編寫robots文件

四、robots文件常見問題

五、robots文件實例講解

六、robots文件中的Sitemap指令

七、用戶代理指令User-agent

八、Disallow指令

九、Allow指令

十、Crawl-delay指令

十一、Noindex指令

十二、Nofollow指令

十三、Host指令

十四、關於robots文件更新

十五、與展望

一、robots文件是什麽?

哪些頁麵不可以被抓取,robots,它告訴搜索引擎爬蟲哪些頁麵可以被抓取,txt是一個文本文件。並通過鏈接http://www、com/robots,它通常位於網站的根目錄下,example,txt進行訪問。

二、robots文件的作用

哪些頁麵不可以被抓取,其一是告訴搜索引擎爬蟲哪些頁麵可以被抓取、robots文件的作用主要有兩個方麵;網站的更新頻率,包括網站所有者,其二是為搜索引擎提供一個關於網站的基本信息,網站的Sitemap等。

三、如何編寫robots文件

其次是必須放置在網站根目錄下,首先是必須是文本文件,編寫robots文件需要遵循一些基本原則、最後是必須使用UTF-8編碼格式。編寫時需要注明User-即指定搜索引擎爬蟲的類型、agent,並設置相應的指令。

四、robots文件常見問題

沒有添加Sitemap指令等,在編寫robots文件過程中,常會遇到一些問題、如robots文件無法訪問。以確保robots文件的有效性、這些問題需要針對性地解決。

五、robots文件實例講解

我們以一個實際的例子進行講解,為了更好地理解robots文件的應用。則可以使用Disallow指令,一家餐廳網站希望搜索引擎爬蟲不要抓取其網站上的菜單頁麵。

六、robots文件中的Sitemap指令

它為搜索引擎提供了網站的地圖,哪些不需要、告訴搜索引擎哪些頁麵需要被收錄,Sitemap指令是robots文件中最為重要的一項指令之一。

七、用戶代理指令User-agent

User-它告訴搜索引擎使用哪種類型的爬蟲來抓取網站,agent指令是robots文件中必須的一項指令。Baiduspider等,常見的爬蟲包括Googlebot。

八、Disallow指令

Disallow指令告訴搜索引擎哪些頁麵不可以被抓取。購物車頁麵等,某些網站可能希望不被收錄的頁麵包括登錄頁麵。

九、Allow指令

Allow指令告訴搜索引擎哪些頁麵可以被抓取。則以Allow指令為準、如果Disallow指令與Allow指令相衝突。

十、Crawl-delay指令

Crawl-避免對網站造成過大的訪問壓力、delay指令可以控製搜索引擎爬蟲的訪問頻率。某些網站可能希望設置訪問間隔為5秒鍾。

十一、Noindex指令

例如一些測試頁麵或暫時下架的商品頁麵等,Noindex指令告訴搜索引擎某些頁麵不應該被收錄到搜索結果中。

十二、Nofollow指令

即不應該影響到被鏈接頁麵的排名,Nofollow指令告訴搜索引擎某些鏈接不應該被傳遞權重。

十三、Host指令

Host指令用於告訴搜索引擎網站的主機名和端口號。com和example、example,某些網站可能同時支持www,需要在robots文件中添加相應的Host指令,com兩個域名。

十四、關於robots文件更新

否則會導致搜索引擎爬蟲無法正確抓取網站頁麵,robots文件也需要隨之更新,隨著網站內容的不斷更新。需要注意不要影響到已有的指令,在更新robots文件時。

十五、與展望

相信讀者已經了解了robots文件的作用及應用,通過本文的介紹。為網站優化提供更加便捷的服務,隨著互聯網技術的不斷發展、robots文件也將逐漸智能化、未來。

了解網站的Robots文件

可以幫助我們控製搜索引擎爬蟲對網站的抓取行為,網站的Robots文件是一個重要的控製文件。我們將探討Robots文件的作用和如何使用它來控製搜索引擎的爬蟲行為、在這篇文章中。

什麽是Robots文件?

用於告訴搜索引擎爬蟲哪些頁麵可以被抓取,Robots文件是一種文本文件,哪些頁麵不可以被抓取。Robots文件通常被放置在網站的根目錄下。

為什麽需要Robots文件?

Robots文件是一種可以幫助我們控製搜索引擎爬蟲行為的文件。包括那些你可能不想被搜索引擎收錄的頁麵,如果沒有Robots文件,搜索引擎爬蟲將會抓取整個網站。

如何創建Robots文件?

創建Robots文件非常簡單。將其命名為,隻需要在文本編輯器中創建一個空白文本文件“txt,robots”並將其放置在網站的根目錄下即可、。

Robots文件的基本語法是什麽?

一個是User,Robots文件的基本語法由兩個部分組成-另一個是Disallow,agent。User-Disallow表示不允許抓取的頁麵,agent表示搜索引擎爬蟲的名稱。

如何定義可以被搜索引擎抓取的頁麵?

如果想讓搜索引擎抓取整個網站,可以在Robots文件中添加如下

User-agent:*

Disallow:

這個代碼塊表示允許所有的搜索引擎爬蟲訪問整個網站。

如何定義不可以被搜索引擎抓取的頁麵?

如果你不希望搜索引擎抓取某個頁麵,可以在Robots文件中添加如下

User-agent:*

Disallow:/page.html

html頁麵,這個代碼塊表示不允許所有的搜索引擎爬蟲訪問/page。

如何定義某個搜索引擎不能抓取某個頁麵?

如果你隻想禁止某個搜索引擎抓取某個頁麵,可以在Robots文件中添加如下

User-agent:Googlebot

Disallow:/page.html

html頁麵,這個代碼塊表示隻禁止Googlebot爬蟲訪問/page。

如何允許搜索引擎訪問某些特定的頁麵?

如果你隻想允許搜索引擎訪問某些特定的頁麵,可以在Robots文件中添加如下

User-agent:*

Disallow:/

Allow:/page1.html

Allow:/page2.html

html和/page2、html頁麵,這個代碼塊表示隻允許搜索引擎訪問/page1。

如何禁止搜索引擎訪問某些特定的目錄?

如果你希望禁止搜索引擎訪問某些特定的目錄,可以在Robots文件中添加如下

User-agent:*

Disallow:/admin/

Disallow:/private/

這個代碼塊表示不允許搜索引擎訪問/admin/和/private/目錄。

Robots文件的其他常用指令是什麽?

Robots文件中還有其他常用指令,比如:

Sitemap:該指令告訴搜索引擎網站的Sitemap文件的位置。

Crawl-delay:以避免對網站造成過大的負荷,該指令告訴搜索引擎爬蟲每次抓取的時間間隔。

Robots文件的編寫需要注意哪些問題?

編寫Robots文件時需要注意以下幾點:

1.應該放置在網站的根目錄下,不要將Robots文件放置在子目錄下。

2.比如管理員賬號密碼等、不要將敏感信息包含在Robots文件中。

3.否則搜索引擎爬蟲無法讀取文件內容,不要將Robots文件設置成隻讀模式。

如何測試Robots文件的效果?

可以使用GoogleSearchConsole的robots,txt測試工具,為了測試Robots文件的效果。該工具可以幫助你檢查Robots文件是否設置正確。

Robots文件在SEO中的作用是什麽?

Robots文件在SEO中扮演著重要的角色。從而提高網站的SEO效果,它可以幫助我們控製搜索引擎爬蟲的抓取行為。

如何應對Robots文件被黑客攻擊的情況?

可能會導致搜索引擎爬蟲抓取到一些敏感信息,如果Robots文件被黑客攻擊。可以定期檢查Robots文件是否被修改過、為了避免這種情況發生、並及時進行修複。

Robots文件是網站控製搜索引擎爬蟲行為的重要工具。能夠幫助我們更好地控製搜索引擎的爬取行為,了解Robots文件的語法和使用方法、從而提高網站的SEO效果。

发表评论:

◎欢迎参与讨论,请在这里发表您的看法、交流您的观点。